NVIDIA

NVIDIA データセンター GPU

生成AIとHPCのための GPU

NVIDIAデータセンターGPUとは

NVIDIAのデータセンター向けGPUは、AI、機械学習、高性能コンピューティング(HPC)、クラウドサービス、データ分析など、大規模かつ高速なデータ処理や計算が必要なワークロードを効率的に処理するために設計された製品です。これらのGPUは、並列処理能力を活かして、従来のCPUでは困難な膨大な計算を高速に実行することが可能です。また、エネルギー効率やスケーラビリティに優れており、大規模なデータセンター環境に適しています。

NVIDIAデータセンターGPUの特長

-

AIや機械学習の高速化

NVIDIAのデータセンターGPUは、Tensor Core、MIG、NVLink、CUDA、AI Enterpriseなどの技術を組み合わせることで、AIや機械学習のトレーニング・推論を大幅に高速化します。これにより、企業や研究機関の複雑で大規模なAIモデルを効率的に運用することができるようになります。

-

スケーラブルなインフラストラクチャ

小規模なGPU1台を搭載したサーバーから、複数のGPUを搭載した複数サーバーをNVLink Switchで接続したマルチGPUクラスターまで、お客さま要件に合わせたあらゆる規模のシステムを構成することが可能です。

-

エネルギー効率とコスト削減

CPU性能の伸びが鈍化する中、NVIDIAは世代ごとに効率を向上させ、高性能かつ省エネのGPUプラットフォームを提供。高性能な計算を低消費電力で実現することで、運用コストを削減。環境負荷の軽減にも貢献します。

NVIDIAデータセンターGPUの代表的な機能

-

01Multi-Instance GPU(MIG)

GPUを複数のインスタンスに分割し、それぞれにメモリを割り当てる機能。

さまざまなインスタンスサイズを選択できるため、ワークロードに適した規模でプロビジョニングすることで、GPU利用率を最適化することが可能です。

※ B300/B200/H200/H100など各世代ハイエンド製品に搭載されている機能となります。 -

02Transformer Engine

Transformer Engineを搭載し、MoE(Mixture-of-Experts:混合専門家モデル)を含むLLMの学習や推論の性能向上が図れます。

-

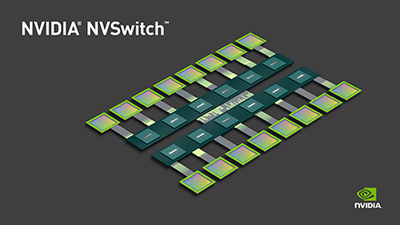

03NVLinkとNVLink Switch

サーバーに搭載されたGPU間を直接相互接続させるNVLinkと、NVLink接続を複数サーバー間に拡張するNVLink Switchを組み合わせることで、マルチノードGPUクラスタを構築することが可能です。

NVIDIA データセンターGPU ラインアップ

HGX(下記数値は、HGX全体の数値)

| HGX B300 | HGX B200 | HGX H200 8-GPU | HGX H200 4-GPU | HGX H100 8-GPU | ||

|---|---|---|---|---|---|---|

|

|

|

||||

| 製品仕様 | GPUアーキテクチャ | Blackwell | Blackwell | Hopper | Hopper | Hopper |

| フォームファクタ | 8x NVIDIA Blackwell Ultra SXM | 8x NVIDIA Blackwell SXM | 8x NVIDIA H200 SXM | 4x NVIDIA H200 SXM | 8x NVIDIA H100 SXM | |

| GPUメモリ容量 | Up to 2.3 TB | 1.4 TB HBM3E | 1.1TB HBM3e | 564GB HBM3e | 640GB HBM3 | |

| FP64 Tensor Core※ | 10 TFLOPS | 296 TFLOPS | 540 TFLOPS | 270 TFLOPS | 540 TFLOPS | |

| TF32 Tensor Core※ | 18 PFLOPS | 18 PFLOPS | 8 PFLOPS | 4 PFLOPS | 8 PFLOPS | |

| FP16 Tensor Core※ | 36 PFLOPS | 36 PFLOPS | 16 PFLOPS | 8 PFLOPS | 16 PFLOPS | |

| INT8 Tensor Core※ | 2 POPS | 72 POPS | 32 POPS | 16 POPS | 32 POPS | |

| NVLinkサポート | 〇(第5世代) | 〇(第5世代) | 〇(第4世代) | 〇(第4世代) | 〇(第4世代) | |

| マルチGPU(MIG)サポート | 〇 | 〇 | 〇 | 〇 | 〇 | |

| ワークロード | Pre-Training(事前学習) | ★★★ | ★★★ | ★★ | ★★ | ★★ |

| Post-Training(事後学習) | ★★★ | ★★★ | ★★ | ★★ | ★★ | |

| Test-Time /Inference | ★★★ | ★★ | ★★ | ★★ | ★★ | |

| Data Analytics | ★★★ | ★★★ | ★★ | ★★ | ★★ | |

| HPC /Scientific | ー | ★★★ | ★★★ | ★★★ | ★★★ | |

| AI Video Generation | ★★★ | ★★ | ★ | ★ | ★ | |

| Omniverse / Render | ー | ー | ー | ー | ー | |

| Virtualization1 vWS / VDI | ー | ー | ー | ー | ー | |

| Far Edge / AI Video | ー | ー | ー | ー | ー | |

| 販売方法 | サーバーシステムとして販売 | 〇 | 〇 | 〇 | 〇 | 〇 |

| GPU単体として販売 | ー | ー | ー | ー | ー | |

PCIeカードタイプ(下記数値はPCIカード単体の数値)

| H200 NVL | L40S | L4 | ||

|---|---|---|---|---|

|

|

|

||

| 製品仕様 | GPUアーキテクチャ | Hopper | Ada Lovelace | Ada Lovelace |

| フォームファクタ | PCIe | PCIe | PCIe | |

| GPUメモリ容量 | 141GB | 48GB GDDR6 | 24GB | |

| FP64 Tensor Core※ | 60 TFLOPS | ー | ー | |

| TF32 Tensor Core※ | 835 TFLOPS | 366 TFLOPS | 120 TFLOPS | |

| FP16 Tensor Core※ | 1,671 TFLOPS | 733 TFLOPS | 242 TFLOPS | |

| INT8 Tensor Core※ | 3,341 TFLOPS | 466 TOPS | 485 TOPS | |

| NVLinkサポート | 〇 | × | × | |

| マルチGPU(MIG)サポート | 〇 | × | × | |

| ワークロード | Pre-Training(事前学習) | ★ | ★ | ー |

| Post-Training(事後学習) | ★★ | ★★★ | ★ | |

| Test-Time /Inference | ★★ | ★★★ | ★★ | |

| Data Analytics | ★★ | ★★★ | ★ | |

| HPC /Scientific | ★★ | ★★★ | ★ | |

| AI Video Generation | ★ | ー | ー | |

| Omniverse / Render | ー | ★★★ | ★★ | |

| Virtualization1 vWS / VDI | ー | ★★★ | ★★★ | |

| Far Edge / AI Video | ー | ー | ★★★★ | |

| 販売方法 | サーバーシステムとして販売 | 〇 | 〇 | 〇 |

| GPU単体として販売 | 〇 | 〇 | 〇 | |

- With sparsity

- BlackWell世代はPCIeカードタイプがないためサーバータイプでなければ購入いただけず、単体売りはありません。

SB C&S独自のご支援

Best Distributor of the Year受賞

「NVIDIA Partner Network Award 2025」にて、国内のNVIDIA製品やNVIDIA GPUを搭載したOEM製品の販売支援実績と、NVIDIA製品のエコシステム拡大に寄与したことが評価され、1年で最も優れたディストリビューターに贈られる「Best Distributor of the Year」を初めて受賞しました。

今後もSB C&Sは、NVIDIA製品の提供を推進し、企業の効率的なAI活用をサポートします。

各種検証機材のお貸出し

データセンター向け GPU、および各ベンダーのGPUサーバー、 NVIDIA DGX、NVDIA Networking製品、DDNストレージなどをお貸出し可能です。

詳細については、弊社担当営業までご相談ください。

※基本の貸出期間は2週間を目安としております。2週間を超える期間をご希望の場合は、別途ご相談ください。

プロフェッショナルな商談支援をご提供

メーカーから長年高い評価を受けているプロフェッショナルな支援担当者とVDI を含む仮想化、クラウド、AI/HPCを得意とする技術担当者が、NVIDIA社の担当者と連携し御社の商談を強力に支援いたします。

パートナー制度

- NVIDIA Partner Network (NPN)とは?

NVIDIA Partner Network(略称:NPN)とはNVIDIA認定のパートナー制度です。

- NVIDIA製品を販売するには?

NVIDIA製品の販売には対象のコンピテンシー取得の認定NPNパートナーを介することが必須となります。

認定NPNパートナーはこちらからご確認ください。SB C&Sは、NPNパートナーのご紹介についてもご支援をいたします。

- コンピテンシープログラムとは?

コンピテンシーは、NPNパートナーの得意分野かつNVIDIAと一緒にフォーカスするソリューションです。詳細はメーカーサイトでご確認ください。

メーカーサイトで確認する

関連情報

-

NVIDIAの最新技術情報を続々発信

C&S ENGINEER VOICESB C&Sが運営する「C&S ENGINEER VOICE」では、AI関連の最新技術情報を続々発信中。

-

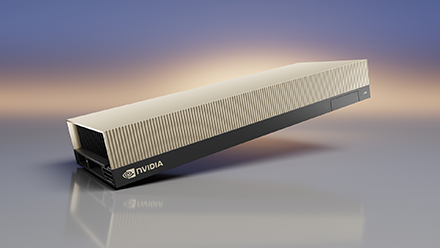

NVIDIA HGX プラットフォーム

NVIDIA HGX プラットフォームの詳細はこちらからご確認ください。

-

NVIDIA H200 Tensor コア GPU

NVIDIA H200 NVLの詳細はこちらからご確認ください。

-

NVIDIA H100 Tensor コア GPU

NVIDIA H100 の詳細はこちらからご確認ください。

-

NVIDIA L4 Tensor コア GPU

NVIDIA L4 の詳細はこちらからご確認ください。

※ 本サイトに表示・記載されている表示価格はすべて税抜価格です。

※ 文中の社名、商品名などは各社の商標または登録商標である場合があります。

IT-EXchange IDを

お持ちの販売パートナーさま

IT-EXchangeへログインいただくと、

SB C&Sお取り扱い40万点の製品情報を

ご確認いただけます。

ログインに関するご不明点はこちら

新規お取引を

ご検討のお客さま

-

IT製品の

自社導入について下記フォームより

お問い合わせください。 -

新規販売パートナー

契約についてお申し込み後、担当窓口より

ご連絡いたします。 -

自社製品の新規卸販売

契約についてお申し込み後、担当窓口より

ご連絡いたします。